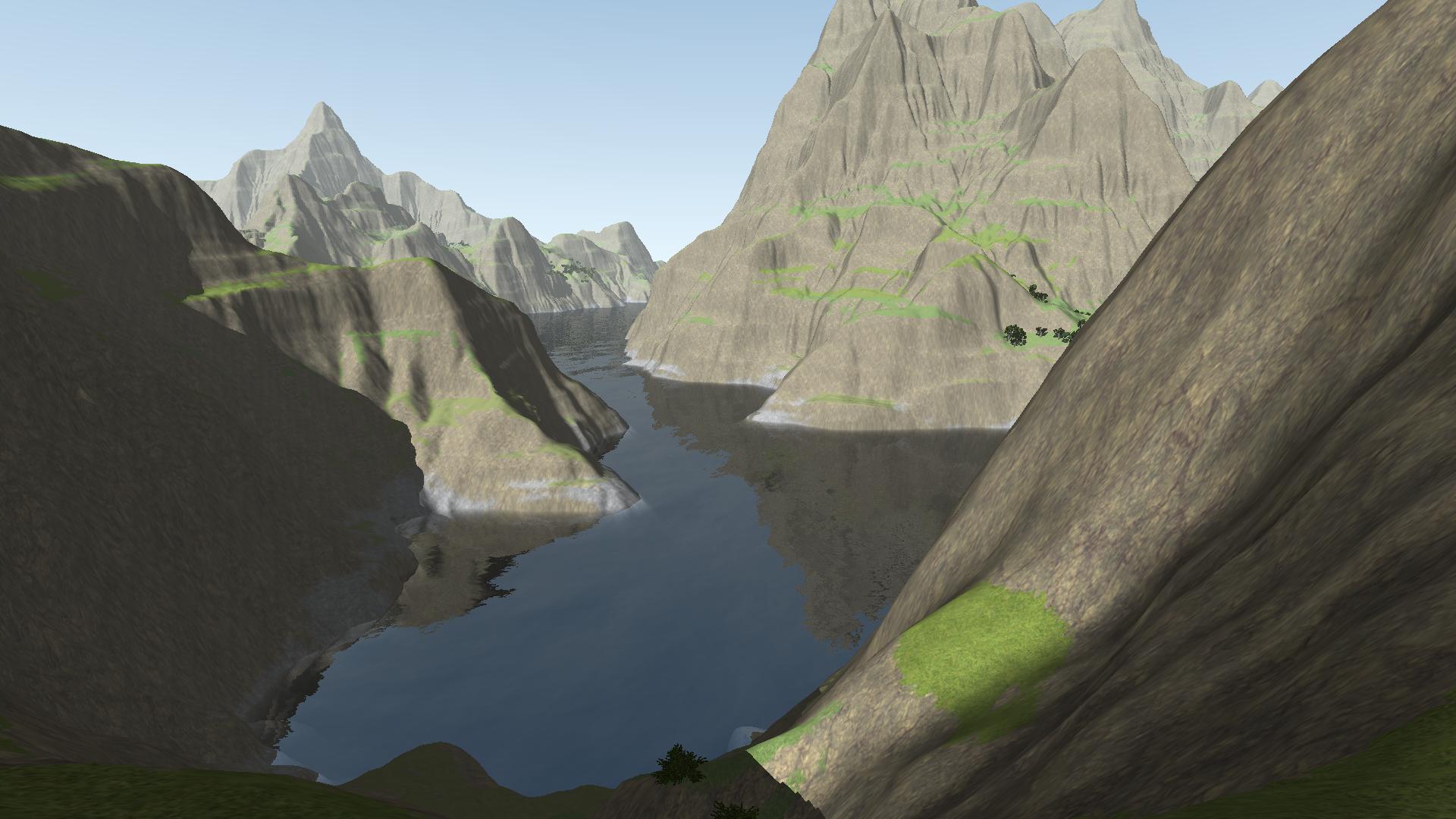

Sparse Voxel Octree Engine Unity Connect

Accelerated Sparse Voxel Octree Pdf Graphics Processing Unit Graphics Sparse attention的核心思想 sparse attention 的核心思想是避免计算每对元素之间的关系,而是仅计算序列中最重要的元素之间的关系。这样可以显著降低计算复杂度和内存占用。 具体来说,sparse attention采用了一些策略来选择性地忽略一些关系,这些策略包括: 固定模式稀疏化:这种方法预定义了一个. 深度学习论文中经常看到"sparse",所以应该是重要的概念,但一直不理解很困惑; 刚才在quora上的回答感觉很有帮助,尝试总结以下: sparse 代表数据为0,sparse数据的存在让不为0的dense数据聚集在一起; 因为存在数据聚集效应,所以才能学到特征和规律; 如果数据维度很高,噪音很多,原本为0的.

Sparse Voxel Octree Engine Unity Connect Sparse transformer 减轻计算量的方式通过让连接模式作用到 上,从而减轻 的复杂度。 如式 (3)。 对于第 个时间片的输入,首先使用 key 和 value 的权值矩阵乘以输入特征,得到 和 。 然后再将连接模式 作用到 和 上,得到稀疏的特征 和 。. 准确率上,sparse 的模型比 full 还要搞一些。 这个我猜一点原因:(1)模型还不算大,nsa 和 full 还没遇到“瓶颈”,所以 full attention 还没摸到其上限,不能和 nsa 拉开差距;(2)sparse attention 本质上可以看做是对训练的一种正则,所以也许会有更好的泛化能力。. 要回答什么是sparse feature,可能首先要理解什么是feature。 一般在machine learning意义上,我们常说的feature,是一种对数据的表达。当然,要衡量一种feature是否是合适的表达,要根据数据,应用,ml的模型,方法 .很多方面来看。 一般来说,feature应该是informative(富有信息量),discriminative(有区分性. 说回sparse residency,sparse residency的buffer除了不需要全部驻留外,与仅仅sparse binding的buffer别无二致。 绑定时候的对齐和粒度条件也一模一样,由alignment决定。 buffer是否支持sparse residency可以通过 vkphysicaldevicefeatures (3) 中的sparseresidencybuffer来查询到。.

Sparse Voxel Octree Engine Unity Connect 要回答什么是sparse feature,可能首先要理解什么是feature。 一般在machine learning意义上,我们常说的feature,是一种对数据的表达。当然,要衡量一种feature是否是合适的表达,要根据数据,应用,ml的模型,方法 .很多方面来看。 一般来说,feature应该是informative(富有信息量),discriminative(有区分性. 说回sparse residency,sparse residency的buffer除了不需要全部驻留外,与仅仅sparse binding的buffer别无二致。 绑定时候的对齐和粒度条件也一模一样,由alignment决定。 buffer是否支持sparse residency可以通过 vkphysicaldevicefeatures (3) 中的sparseresidencybuffer来查询到。. Sparse特征通常指的是那些具有大量可能值但实际使用值很少的特征,例如用户浏览过的商品id。 这些特征在数据集中往往有很多零值,因此被称为稀疏。 在sparse双塔模型中,稀疏特征通常通过one hot编码或者稀疏表示(如tf idf)来处理。. 在人工智能的浩瀚星空中,每一次技术的跃迁都如同点亮了一颗新星,吸引着无数研究者和爱好者的目光。近期,openai发布的sparse autoencoder无疑成为了这一星空中的璀璨焦点,引发了圈内广泛的讨论和关注。那么,作为知乎上的一名知识探索者,我们该如何审视这一技术,理解其背后的意义和潜在的. 稀疏矩阵(sparse matrix)的基本数据结构实现 稀疏矩阵(sparse matrix)的基本数据结构实现 立党 朋克 99 人赞同了该文章. Categorical crossentropy:计算预测值与真值的多类交叉熵 (输入值为二值矩阵,而不是向量),注意使用该目标函数时,需要将标签转化为形如 (nb samples, nb classes) 的二值序列 sparse categorical crossentropy:与多类交叉熵相同,适用于稀疏情况。如上,但接受稀疏标签。注意,使用该函数时仍然需要你的标签与输出值.

Sparse Voxel Octree Github Topics Github Sparse特征通常指的是那些具有大量可能值但实际使用值很少的特征,例如用户浏览过的商品id。 这些特征在数据集中往往有很多零值,因此被称为稀疏。 在sparse双塔模型中,稀疏特征通常通过one hot编码或者稀疏表示(如tf idf)来处理。. 在人工智能的浩瀚星空中,每一次技术的跃迁都如同点亮了一颗新星,吸引着无数研究者和爱好者的目光。近期,openai发布的sparse autoencoder无疑成为了这一星空中的璀璨焦点,引发了圈内广泛的讨论和关注。那么,作为知乎上的一名知识探索者,我们该如何审视这一技术,理解其背后的意义和潜在的. 稀疏矩阵(sparse matrix)的基本数据结构实现 稀疏矩阵(sparse matrix)的基本数据结构实现 立党 朋克 99 人赞同了该文章. Categorical crossentropy:计算预测值与真值的多类交叉熵 (输入值为二值矩阵,而不是向量),注意使用该目标函数时,需要将标签转化为形如 (nb samples, nb classes) 的二值序列 sparse categorical crossentropy:与多类交叉熵相同,适用于稀疏情况。如上,但接受稀疏标签。注意,使用该函数时仍然需要你的标签与输出值.

Github Cianjinks Sparse Voxel Octree Implementing Sparse Voxel 稀疏矩阵(sparse matrix)的基本数据结构实现 稀疏矩阵(sparse matrix)的基本数据结构实现 立党 朋克 99 人赞同了该文章. Categorical crossentropy:计算预测值与真值的多类交叉熵 (输入值为二值矩阵,而不是向量),注意使用该目标函数时,需要将标签转化为形如 (nb samples, nb classes) 的二值序列 sparse categorical crossentropy:与多类交叉熵相同,适用于稀疏情况。如上,但接受稀疏标签。注意,使用该函数时仍然需要你的标签与输出值.

Sparse Voxel Octree Raycasting Development Blog Ultra Engine

Comments are closed.