Lru Cache Twitch Interview Leetcode 146

146 Lru Cache Leetcode 谢邀。 一般用树形结构的伪lru来近似lru实现cache或tlb条目的淘汰算法。 (我当年还在我们单位的cpu模拟器上把tlb的round robin淘汰算法替换成了plru对比测试了spec2006某课题的tlb缺失率,发现没有什么改善,,,). 首先说一个问题 lru就是最近最久未使用页面淘汰算法,他的思想是:把最长时间内未被访问过的页面淘汰出去。lfu是最近最少使用页面淘汰算法,思想是:总是把当前使用的最少的页面淘汰出去。 单从字面上看,好像这两种 算法 差不多,也很难理解。但我们给我一个例子你就完全明白了: 比如.

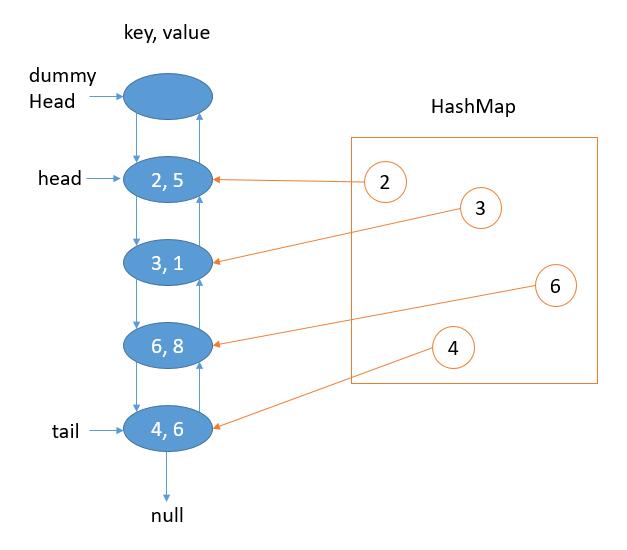

花花酱 Leetcode 146 Lru Cache O 1 Huahua S Tech Road Lru 实现 如果通过一个栈来实现,每次 get 值后都需要进行排序,会带来一些额外的时间复杂度。 如果需要从 o (1) 时间复杂度内解决问题,一般会使用 hash table doubly linked list 的方式。 hash table:o (1) 时间复杂度查找元素。 doubly linked list:o (1) 时间复杂度增删改. 为了演示lru,使用 linkedhashmap 类来实现一个lur缓存, 因为它内部已经处理了哈希表和双向链表,哈希表提供了快速的插入和查找操作(平均时间复杂度为o (1)),而双向链表则维护了元素的插入顺序或访问顺序(取决于构造函数的参数),代码如下:. 目录 lru缓存替换策略 核心思想 不适用场景 算法基本实现 算法优化 进一步优化 benchmark lru缓存替换策略 缓存是一种非常常见的设计,通过将数据缓存到访问速度更快的存储设备中,来提高数据的访问速度,如内存、cpu缓存、硬盘缓存等。 但与缓存的高速相对的是,缓存的成本较高,因此容量往往. 谢邀。 书上写的有一些问题,一般不是用随机替换,是用pseudo lru,也就是伪lru,也有缩写plru的。 lru极少在cache里面被采用主要是因为实现开销太大,逻辑层数和per way的访问历史存储要求都远高过其他替换策略,但是效果却没有好多少,我看到的实测数据是,从lru到纯随机替换,miss rate只有百分之.

Leetcode 146 Lru Cache How To Solve The Popular Coding By 目录 lru缓存替换策略 核心思想 不适用场景 算法基本实现 算法优化 进一步优化 benchmark lru缓存替换策略 缓存是一种非常常见的设计,通过将数据缓存到访问速度更快的存储设备中,来提高数据的访问速度,如内存、cpu缓存、硬盘缓存等。 但与缓存的高速相对的是,缓存的成本较高,因此容量往往. 谢邀。 书上写的有一些问题,一般不是用随机替换,是用pseudo lru,也就是伪lru,也有缩写plru的。 lru极少在cache里面被采用主要是因为实现开销太大,逻辑层数和per way的访问历史存储要求都远高过其他替换策略,但是效果却没有好多少,我看到的实测数据是,从lru到纯随机替换,miss rate只有百分之. 上述“主要的页面替换算法”包括但不限于:opt、fifo、lru、lfu、clock。 为什么说lru实现起来开销最大呢?是因为排序的问题吗?这里所说… 显示全部 关注者 2 被浏览 3,237. Lru lru(least recently used)是一种缓存置换算法。即优先丢弃最近不常用的缓存项。lru的实现相对而言比较简单,可以将缓存项按照访问时间排序,当新的缓存项加入时可以以o (1)的时间复杂度找到并丢弃最近不常用的缓存项。lrucache可以认为是将lru作为缓存置换算法的缓存(不过一般可以不需要区分. 分析 要让 lru 的 put 和 get 方法的时间复杂度为 o (1),可以总结出 lru 这个数据结构必要的条件: 显然 lru 中的元素必须有时序,以区分最近使用的和久未使用的数据,当容量满了之后要删除最久未使用的那个元素腾位置。. Lrm与lru的主要区别在于lrm层级更低一些,其相同点是二者均可在航线上直接替换。 如今电子设备集成度越来越高,测试性也做的很好。 维修性趋向于两级发展,即在外场故障定位到板卡级lrm,实现故障lrm的更换,更换后由总部或厂家维修。.

Comments are closed.